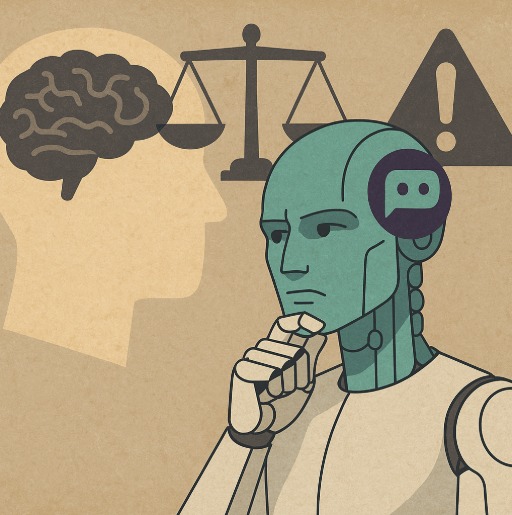

A ascensão da inteligência artificial generativa, exemplificada por sistemas como o ChatGPT, transformou de forma acelerada o modo como o conhecimento é produzido e consumido. No campo jurídico, a ferramenta passou a ser utilizada na redação de petições, pareceres, decisões e até na pesquisa acadêmica.

Entretanto, o uso crescente dessas tecnologias suscita uma preocupação central: o enfraquecimento do pensamento crítico. Ao oferecer respostas imediatas e convincentes, a IA tende a reduzir o espaço da reflexão, da dúvida e da construção autônoma do raciocínio pilares da ciência jurídica e da própria democracia.

Este artigo analisa, sob uma perspectiva jurídico-filosófica, os riscos da automatização do pensamento no Direito e propõe caminhos regulatórios e educacionais para que o uso da IA preserve a autonomia intelectual humana.

Modelos de linguagem como o ChatGPT funcionam a partir de redes neurais treinadas com bilhões de textos, gerando respostas com aparência de raciocínio. Apesar de sua sofisticação, o sistema não compreende o conteúdo: apenas prevê a sequência mais provável de palavras.

Essa característica coloca em evidência um dilema contemporâneo: quanto mais convincente é o texto gerado por IA, maior o risco de aceitá-lo como verdadeiro sem a devida verificação crítica.

No ambiente jurídico, isso se traduz em petições e pareceres “corretos” formalmente, mas vazios de reflexão interpretativa, reduzindo o Direito a uma operação técnica, desprovida de prudência e ponderação.

Como adverte Byung-Chul Han (2017), a sociedade hiperconectada corre o risco de substituir o pensar pelo “funcionar”.

O pensamento crítico é o núcleo da racionalidade jurídica. Ele implica questionar premissas, interpretar contextos e ponderar princípios, transformando o texto legal em justiça aplicada.

Para o jurista, pensar criticamente significa desconfiar do óbvio, revisar interpretações e buscar coerência com os valores constitucionais.

A inteligência artificial, ao reproduzir padrões estatísticos de linguagem, não pode exercer essa função interpretativa.

Ronald Dworkin (1986) defendeu que o Direito requer “decisões com integridade”, ou seja, baseadas na coerência e moralidade do sistema jurídico. Uma decisão ou parecer automatizado, sem reflexão humana, carece dessa integridade apenas um simulacro de raciocínio jurídico.

O uso jurídico do ChatGPT envolve responsabilidades éticas e legais relevantes:

O Estatuto da Advocacia (Lei 8.906/94) estabelece a responsabilidade pessoal do advogado pelos atos que pratica. Assim, mesmo que utilize IA, é o profissional quem responde por erros, omissões ou informações falsas.

No Poder Judiciário, a fundamentação das decisões (art. 93, IX, da CF)é indelegável: o juiz não pode transferir à IA o dever de motivar.

- Proteção de dados e governança algorítmica

A Lei Geral de Proteçâo de Dados (Lei 13.709/2018) impõe princípios de transparência e segurança, aplicáveis também às empresas que desenvolvem sistemas de IA.

O tratamento de dados para treinamento de modelos deve respeitar a finalidade e o consentimento dos titulares, sob pena de violar direitos fundamentais.

A OAB e diversas universidades têm debatido o uso ético da IA. A redação de textos jurídicos por IA sem revisão ou crítica humana pode configurar violação à ética profissional e até plágio técnico, uma vez que a autoria intelectual deve ser humana e consciente.

A ferramenta deve ser compreendida como apoio à produção intelectual, não como substituto do raciocínio.

No ensino jurídico, a facilidade proporcionada pela IA cria um paradoxo: quanto mais acesso à informação, menor o esforço cognitivo exigido do estudante.

Trabalhos e petições elaborados por ChatGPT podem parecer sofisticados, mas raramente expressam compreensão genuína.

A solução não é proibir o uso da IA, mas ensinar a pensar sobre ela desenvolver o que se pode chamar de literacia algorítmica, isto é, a capacidade de compreender, criticar e supervisionar tecnologias cognitivas.

O jurista do futuro não será aquele que recusa a tecnologia, mas aquele que a utiliza com discernimento ético e crítico, preservando o papel humano da interpretação.

Conclusão

O ChatGPT não é um inimigo do pensamento crítico, mas o espelho de sua fragilidade contemporânea.

Quando o jurista se limita a reproduzir respostas prontas, abdica da função essencial de interpretar, ponderar e decidir com autonomia.

A tecnologia pode e deve ser aliada da Justiça, desde que submetida ao controle ético e reflexivo do ser humano.

O verdadeiro risco não está em a máquina pensar por nós, mas em nós deixarmos de pensar porque ela o faz mais rápido.

Em tempos de automação cognitiva, pensar continua sendo o ato mais revolucionário e mais humano do Direito.

Por Déborah Rocha.

Déborah Rocha é Bacharel em Direito, e Pós Graduanda em Direito Licitatório e Contratações Públicas.

Alexandre Santos

Alexandre Santos

A PEDIDO DE SAULO HOLANDA, HÉLDER PIRES ANUNCIA QUE A SENADORA TERESA LEITÃO DESTINARÁ EMENDA PARA A SAÚDE DE OLINDA

A PEDIDO DE SAULO HOLANDA, HÉLDER PIRES ANUNCIA QUE A SENADORA TERESA LEITÃO DESTINARÁ EMENDA PARA A SAÚDE DE OLINDA